Un recorrido real que muestra cómo el diseño del pipeline y los experimentos iterativos mejoran la precisión en la extracción de documentos a partir de datos reales.

La mayoría de los sistemas de Document AI parecen precisos en demos, pero fallan cuando los documentos vienen agrupados, son inconsistentes o están desordenados. Este flujo de experimentación está diseñado para detectar esos problemas desde el principio, antes de llevar los modelos a producción.

Un recorrido por tres experimentos reales de extracción que muestra cómo el diseño del pipeline, la estructura del documento y la iteración influyen directamente en la precisión en producción.

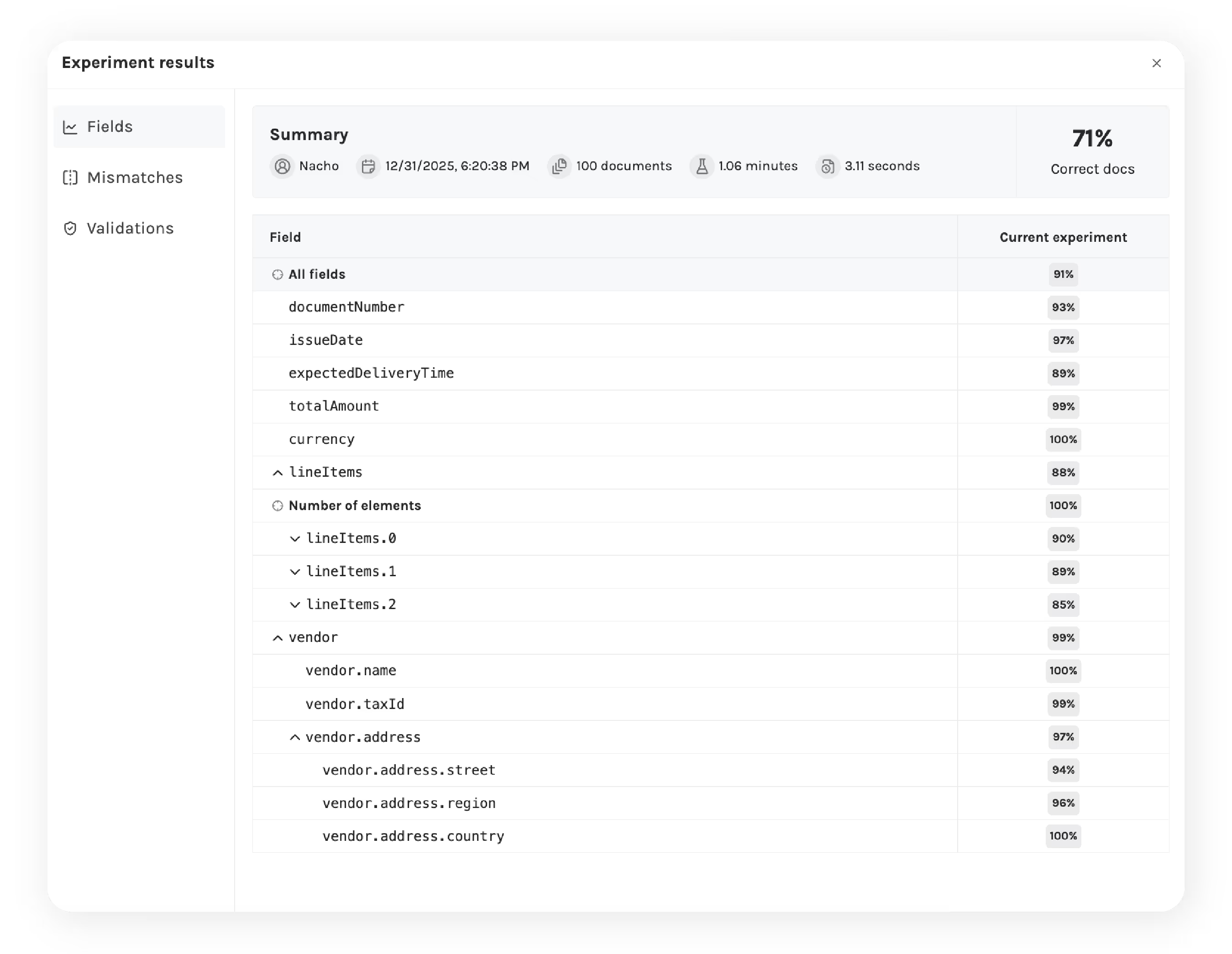

La precisión en la extracción de documentos casi nunca es perfecta en el primer intento. Alcanzar un rendimiento listo para producción requiere visibilidad sobre cómo se comportan los esquemas, dónde se producen los errores y cómo los cambios afectan a los resultados con el tiempo.

En entornos reales, la precisión suele degradarse por motivos previsibles — tipos de documentos mezclados, variaciones de layout, casos límite y cambios en los esquemas. Este flujo de trabajo está diseñado para hacer visibles y medibles esos fallos, en lugar de ocultarlos tras métricas agregadas.

Este marco de experimentación permite a Invofox:

Medir la precisión a nivel de campo y de documento.

Más información sobre cómo medimos la precisión.

Entender la causa raíz de los errores, en lugar de hacer suposiciones.

Comparar cambios entre experimentos con métricas concretas

Decidir con confianza cuándo un modelo está listo para producción para un caso de uso y conjunto de documentos específicos, y actualizarlo cuando hay nuevas versiones de modelos disponibles

El primer ciclo de experimentación comienza ejecutando un pipeline de extracción sencillo sobre documentos proporcionados por el cliente y comparando los resultados con su ground truth.

En esta etapa, los equipos pueden observar:

Precisión a nivel de campo en todos los datos extraídos

Una primera señal de qué campos son estables y cuáles presentan degradación

Una línea base clara para comparar con iteraciones posteriores

En cada experimento, los valores extraídos se comparan directamente con el ground truth proporcionado por el cliente (los valores correctos y esperados para cada campo). Los desajustes se clasifican en categorías de error explícitas para que los modos de fallo sean visibles y accionables, incluyendo:

Ruido de OCR y errores a nivel de carácter

Valores semánticamente equivalentes expresados de forma distinta

Asignaciones incorrectas de campos o valores ausentes

Problemas estructurales en campos anidados o arrays

Esta vista a nivel de documento permite entender por qué ha fallado un campo, no solo que ha fallado.

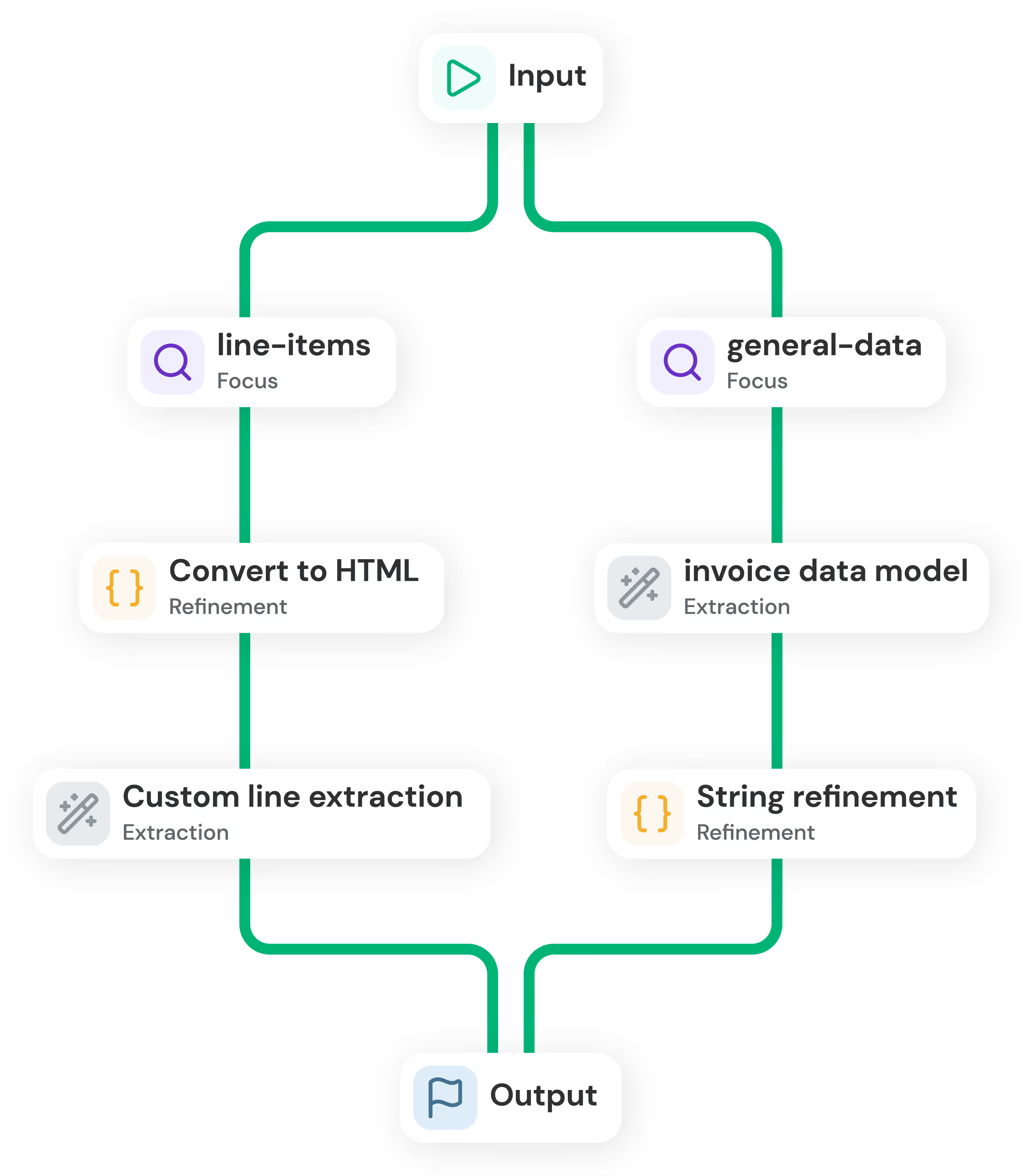

A partir de este análisis, se aplican ajustes específicos al pipeline de extracción, incluyendo el modelo, el diseño del esquema y la lógica de post-procesado. Algunas estrategias habituales son:

Extracción focalizada: dividir esquemas complejos para que distintos modelos extraigan secciones específicas.

Procesamiento de entrada: convertir los documentos a HTML o Markdown para alinearlos mejor con el comportamiento del modelo.

Refinamiento a nivel de campo: aplicar normalización, post-procesado o lógica personalizada a campos inestables.

Especialización de modelos: ejecutar distintos modelos, ajustados por tipo de documento o caso de uso, para mejorar la precisión.

Antes de desplegar en producción, las mejoras se validan en condiciones similares a las reales para asegurar que generalizan más allá del dataset inicial. Esto incluye:

Probar el rendimiento con layouts, proveedores y variantes de documentos no vistos.

Introducir nuevos layouts y casos límite.

Aplicar volúmenes de documentos a escala de producción para detectar degradaciones de precisión o rendimiento.

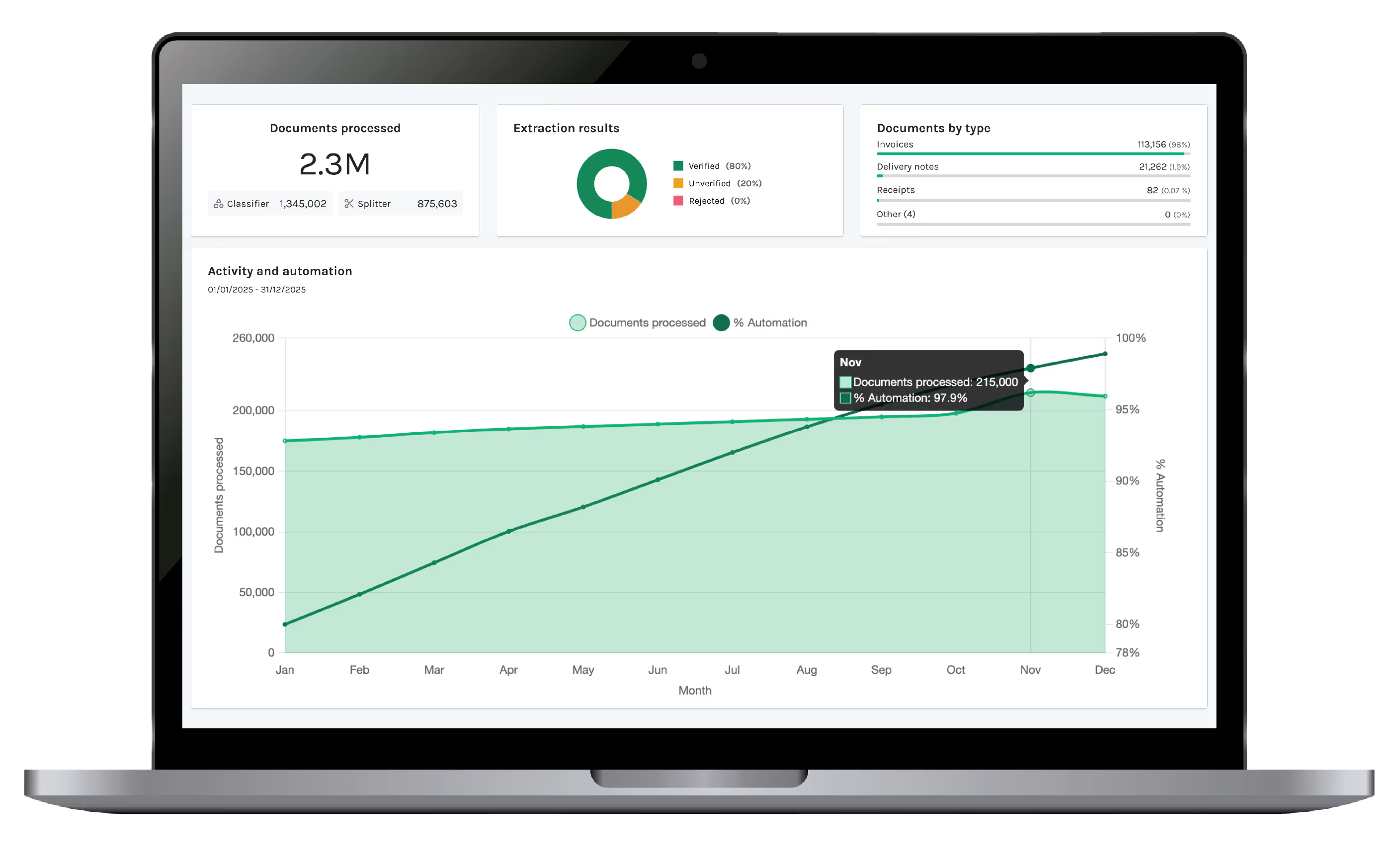

Una vez en producción, la precisión se mejora de forma continua utilizando datos reales y feedback de los clientes:

Incorporar correcciones y feedback del cliente en nuevas iteraciones.

Monitorizar tendencias de precisión y detectar regresiones a lo largo del tiempo.

Adaptar automáticamente los pipelines a medida que evolucionan los documentos, layouts y requisitos.

La mayoría de los sistemas de Document AI se evalúan de forma aislada, con entradas limpias, datasets limitados y condiciones ideales. Sin embargo, la precisión en producción se rompe cuando los documentos se mezclan, los layouts varían y los esquemas evolucionan con el tiempo.

Este flujo de experimentación existe para cerrar esa brecha.

En lugar de tratar la experimentación como un paso puntual u offline, Invofox la integra como una parte fundamental de la plataforma de inteligencia documental — conectando la gestión de entradas, los pipelines de extracción, la medición de precisión y la iteración dentro de un flujo estructurado.

Esto permite a los equipos:

Entender por qué cambia la precisión

Detectar regresiones antes de que afecten a sistemas downstream

Validar mejoras sobre la variabilidad real de documentos, no sobre muestras seleccionadas

Promover pipelines a producción con confianza y adoptar nuevas versiones de modelos de forma segura

Separa y clasifica automáticamente documentos mezclados o agrupados para que los pipelines partan de entradas limpias y correctamente estructuradas. Más información

Mide y compara la precisión a nivel de campo y documento entre experimentos. Más información

Mantiene las mejoras validadas a medida que evolucionan esquemas, documentos y modelos. Más información

Seguimiento de tendencias, estabilidad y regresiones de precisión a lo largo del tiempo. Más información

Ejecuta flujos de extracción y experimentación sin retener documentos ni datos extraídos para casos sensibles o regulados. Más información

La forma más rápida de entender cómo funcionan los flujos reales de inteligencia documental es observar cómo se comportan los experimentos estructurados sobre tus propios documentos — a lo largo de iteraciones, conjuntos de datos y condiciones similares a producción.