Durante una prueba de concepto, Invofox entrega un informe de rendimiento detallado que muestra exactamente cómo se comportan los documentos — en términos de precisión, errores, proveedores, tiempos de procesamiento y edge cases.

Desde los primeros documentos procesados, la precisión nunca es una promesa. Es un resultado definido y medido.

You share a small, representative sample of your documents, including the corresponding ground truth for evaluation.

We analyze the sample set and schema, split it into different parts, and define success upfront: accuracy targets, confidence thresholds, and evaluation criteria.

We iterate in a continuous improvement loop to refine the pipeline, adjust models, and fine-tune the solution to achieve maximum accuracy.

We process the full document volume, handling thousands of documents and pages, not cherry-picked examples.

We deliver a performance report with a clear, visual breakdown of results you can confidently share internally.

Este informe está pensado para compartirse internamente — con equipos técnicos, operativos y directivos — sin necesidad de explicaciones adicionales.

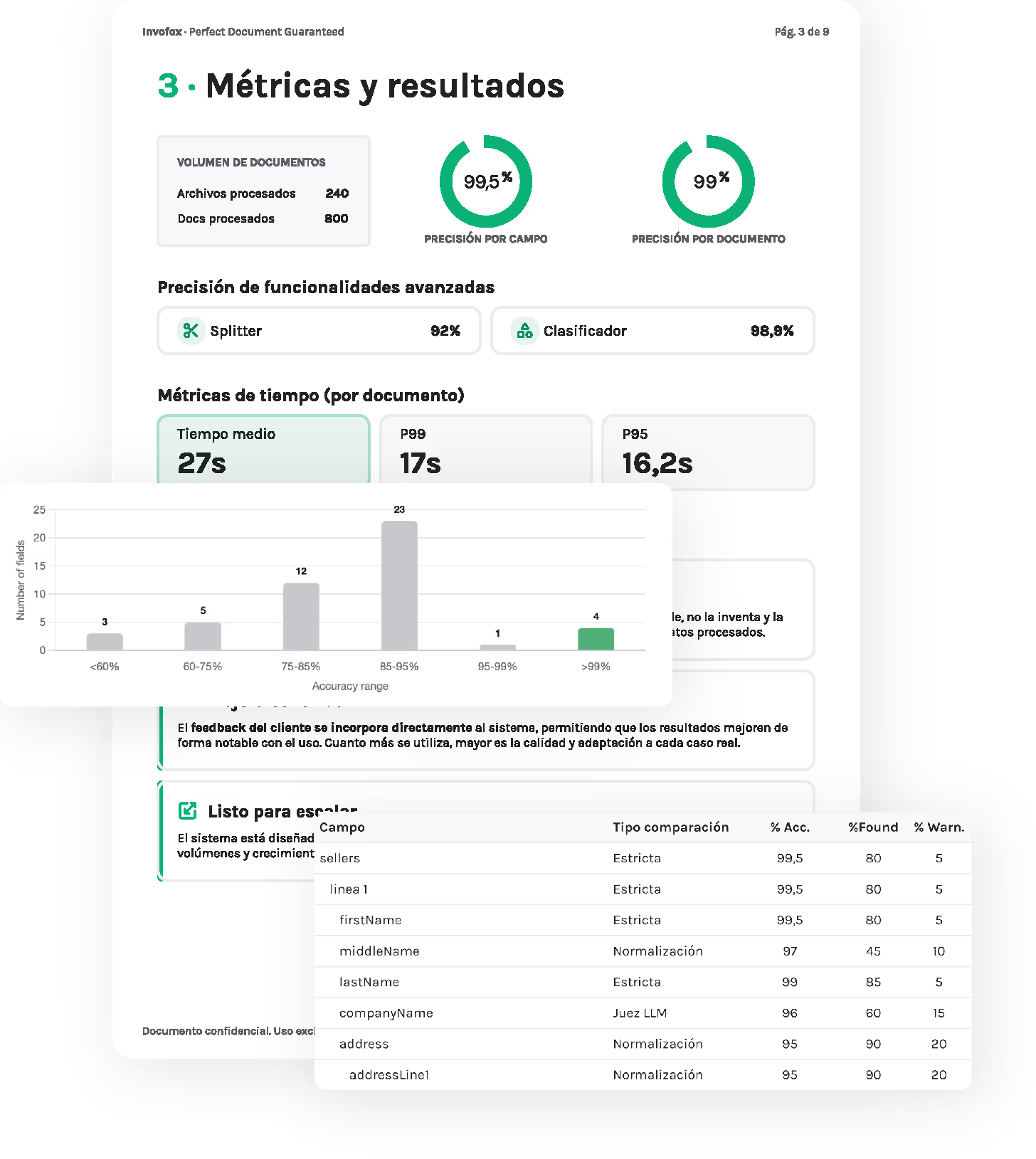

Recibirás informes de rendimiento que incluyen las siguientes métricas y análisis:

Precisión global (a nivel de campo y de documento)

Tiempos de procesamiento (P95 / P99)

Distribución de errores y tipos de fallo

Campos ausentes o con baja confianza

Umbrales de confianza y advertencias

Rendimiento a nivel de página y de documento

Rendimiento de los módulos de splitter y clasificador

Análisis personalizado según tu caso de uso

Todos los resultados se calculan utilizando una metodología de evaluación definida, basada en comparaciones con ground truth, y que se comparten de forma transparente.

Visibilidad total sobre precisión, errores y edge cases — sobre tus documentos.

En lugar de depender de un único valor medio de precisión, Invofox desglosa los resultados de forma que reflejan la complejidad real de los entornos de producción. Esto permite a los equipos centrar los esfuerzos de optimización donde tienen mayor impacto.

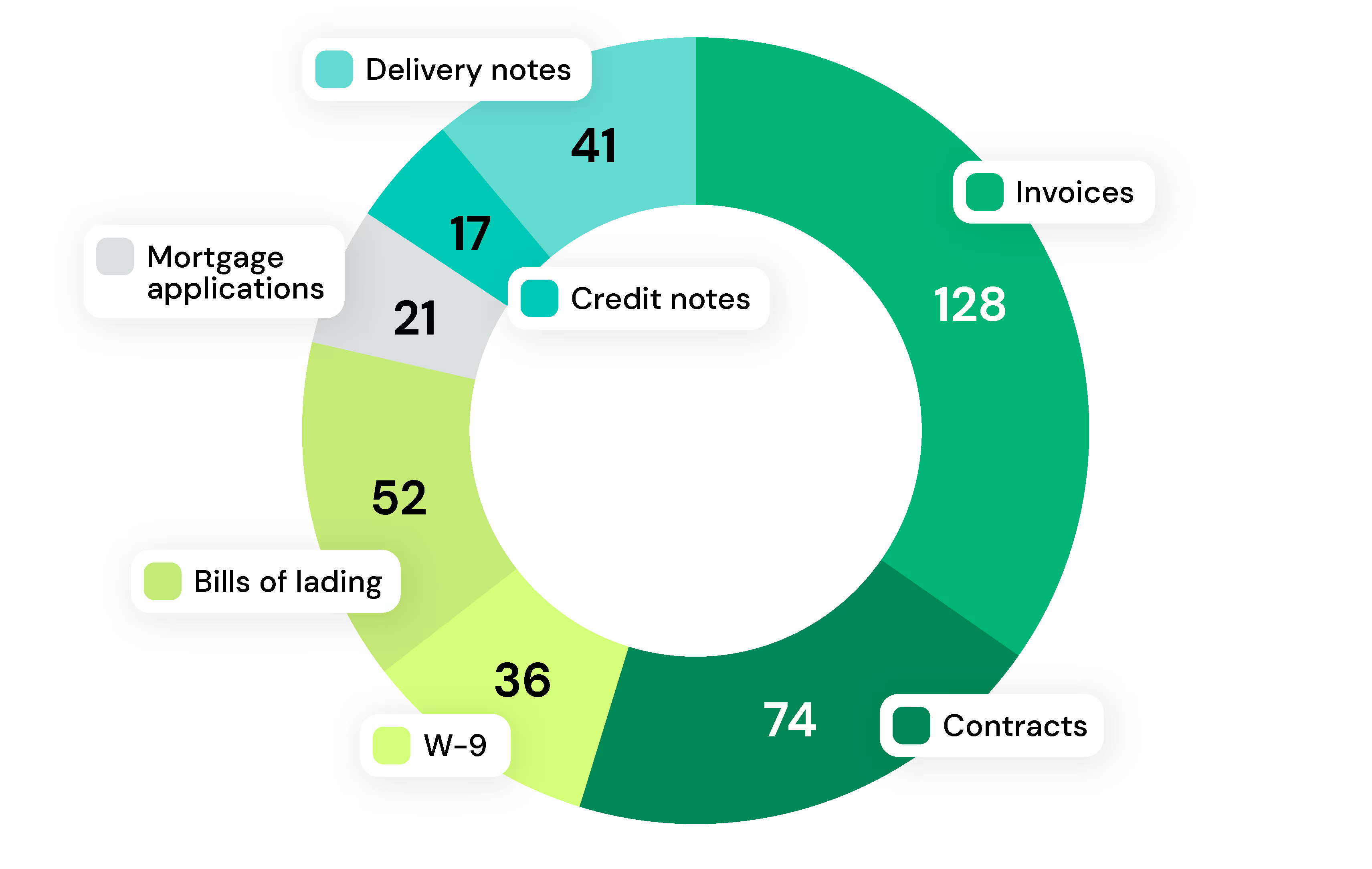

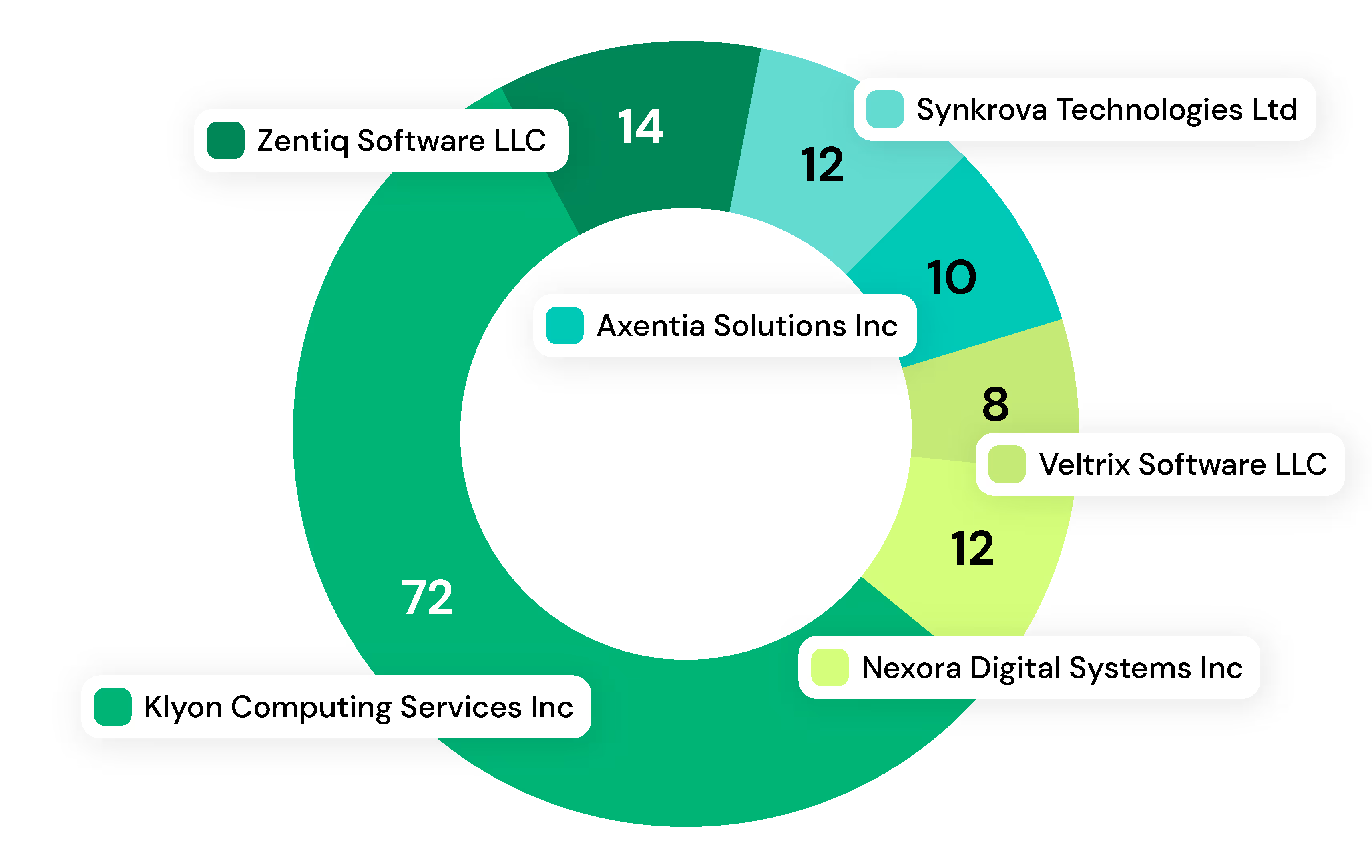

El rendimiento puede segmentarse por distintas dimensiones del documento, entre ellas:

Ejemplos: facturas, contratos, formularios fiscales, conocimientos de embarque, solicitudes hipotecarias y de préstamo, notas de crédito o albaranes, entre otros.

Identifica qué diseños o formatos concentran mayor volumen o variabilidad. Por ejemplo: proveedores en el caso de facturas, estados o regiones en formularios estándar, etc.

En entornos de producción reales, siempre existe un porcentaje de documentos con problemas — baja calidad de imagen, información incompleta, archivos dañados o diseños altamente inconsistentes. Por este motivo, alcanzar una automatización del 100% no suele ser viable en la práctica, independientemente del modelo utilizado.

En despliegues de gran volumen, hemos observado que aproximadamente entre un 5% y un 10% de los documentos pueden entrar en esta categoría, debido exclusivamente a limitaciones de calidad de los datos.

Cada informe detalla claramente qué problemas mejoran con feedback, cuáles requieren ajustes de umbrales y dónde la incorporación de más datos o cambios en el pipeline generará mayor impacto.

Los informes de rendimiento incluyen:

Qué falló y cómo mejorarlo

Por qué falló y propuestas para solucionarlo

Con qué frecuencia ocurrió

Si el problema principal fue:

Información ausente

Diseños ambiguos

Extracciones con baja confianza

Edge cases

Documentos reales, datos reales — un principio fundamental.